Istio:Google、IBM 和 Lyft 联合开源的微服务框架

Istio是Google、IBM和Lyft联合开源的微服务Service Mesh框架,旨在解决大量微服务的发现、连接、管理、监控以及安全等问题。

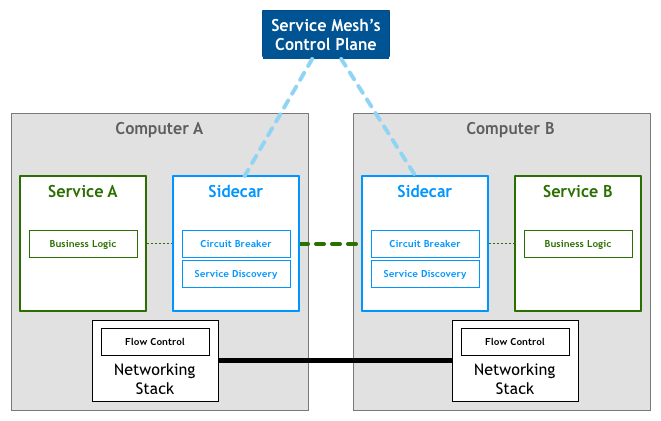

先看一张Service Mesh的架构图

Istio 首先是一个服务网络,但是Istio又不仅仅是服务网格: 在 Linkerd, Envoy 这样的典型服务网格之上,Istio提供了一个完整的解决方案,为整个服务网格提供行为洞察和操作控制,以满足微服务应用程序的多样化需求。

Istio在服务网络中统一提供了许多关键功能(以下内容来自官方文档):

- 流量管理:控制服务之间的流量和API调用的流向,使得调用更可靠,并使网络在恶劣情况下更加健壮。

- 可观察性:了解服务之间的依赖关系,以及它们之间流量的本质和流向,从而提供快速识别问题的能力。

- 策略执行:将组织策略应用于服务之间的互动,确保访问策略得以执行,资源在消费者之间良好分配。策略的更改是通过配置网格而不是修改应用程序代码。

- 服务身份和安全:为网格中的服务提供可验证身份,并提供保护服务流量的能力,使其可以在不同可信度的网络上流转。

除此之外,Istio针对可扩展性进行了设计,以满足不同的部署需要:

- 平台支持:Istio旨在在各种环境中运行,包括跨云, 预置,Kubernetes,Mesos等。最初专注于Kubernetes,但很快将支持其他环境。

- 集成和定制:策略执行组件可以扩展和定制,以便与现有的ACL,日志,监控,配额,审核等解决方案集成。

这些功能极大的减少了应用程序代码,底层平台和策略之间的耦合,使微服务更容易实现。

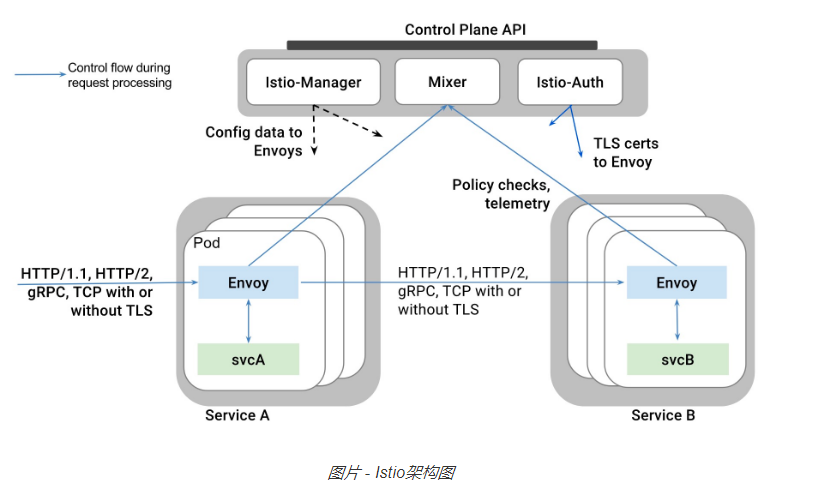

istio架构图

Istio的关键功能包括:

- HTTP/1.1,HTTP/2,gRPC和TCP流量的自动区域感知负载平衡和故障切换。

- 通过丰富的路由规则,容错和故障注入,对流行为的细粒度控制。

- 支持访问控制,速率限制和配额的可插拔策略层和配置API。

- 集群内所有流量的自动量度,日志和跟踪,包括集群入口和出口。

- 安全的服务到服务身份验证,在集群中的服务之间具有强大的身份标识。

原理

Istio从逻辑上可以分为数据平面和控制平面:

- 数据平面主要由一系列的智能代理(Envoy)组成,管理微服务之间的网络通信

- 控制平面负责管理和配置这些智能代理,并动态执行策略

安装

Istio目前仅支持Kubernetes,在部署Istio之前需要先部署好Kubernetes集群并配置好kubectl客户端。

下载Istio

curl -L https://git.io/getIstio | sh -

cd istio-0.1.6/

cp bin/istioctl /usr/local/bin/

创建RBAC角色和绑定

$ kubectl apply -f install/kubernetes/istio-rbac-beta.yaml

clusterrole "istio-pilot" created

clusterrole "istio-ca" created

clusterrole "istio-sidecar" created

rolebinding "istio-pilot-admin-role-binding" created

rolebinding "istio-ca-role-binding" created

rolebinding "istio-ingress-admin-role-binding" created

rolebinding "istio-sidecar-role-binding" created

如果碰到下面的错误

Error from server (Forbidden): error when creating "install/kubernetes/istio-rbac-beta.yaml": clusterroles.rbac.authorization.k8s.io "istio-pilot" is forbidden: attempt to grant extra privileges: [{[*] [istio.io] [istioconfigs] [] []} {[*] [istio.io] [istioconfigs.istio.io] [] []} {[*] [extensions] [thirdpartyresources] [] []} {[*] [extensions] [thirdpartyresources.extensions] [] []} {[*] [extensions] [ingresses] [] []} {[*] [] [configmaps] [] []} {[*] [] [endpoints] [] []} {[*] [] [pods] [] []} {[*] [] [services] [] []}] user=&{user@example.org [...]

需要给用户授予admin权限

kubectl create clusterrolebinding myname-cluster-admin-binding --clusterrole=cluster-admin --user=myname@example.org

部署Istio核心服务

两种方式(选择其一执行)

- 禁止Auth:kubectl apply -f install/kubernetes/istio.yaml

- 启用Auth:kubectl apply -f install/kubernetes/istio-auth.yaml

部署Prometheus、Grafana和Zipkin插件

kubectl apply -f install/kubernetes/addons/prometheus.yaml

kubectl apply -f install/kubernetes/addons/grafana.yaml

kubectl apply -f install/kubernetes/addons/servicegraph.yaml

kubectl apply -f install/kubernetes/addons/zipkin.yaml

等一会所有Pod启动后,可以通过NodePort或负载均衡服务的外网IP来访问这些服务。比如通过NodePort方式,先查询服务的NodePort

$ kubectl get svc grafana -o jsonpath='{.spec.ports[0].nodePort}'

32070

$ kubectl get svc servicegraph -o jsonpath='{.spec.ports[0].nodePort}'

31072

$ kubectl get svc zipkin -o jsonpath='{.spec.ports[0].nodePort}'

30032

$ kubectl get svc prometheus -o jsonpath='{.spec.ports[0].nodePort}'

30890

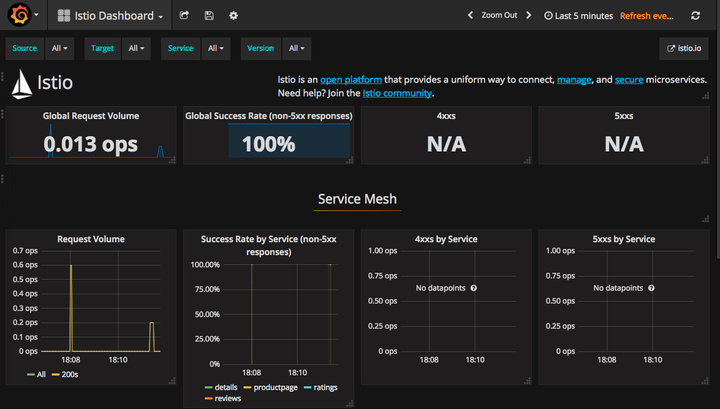

通过http://<kubernetes-ip>:32070/dashboard/db/istio-dashboard访问Grafana服务

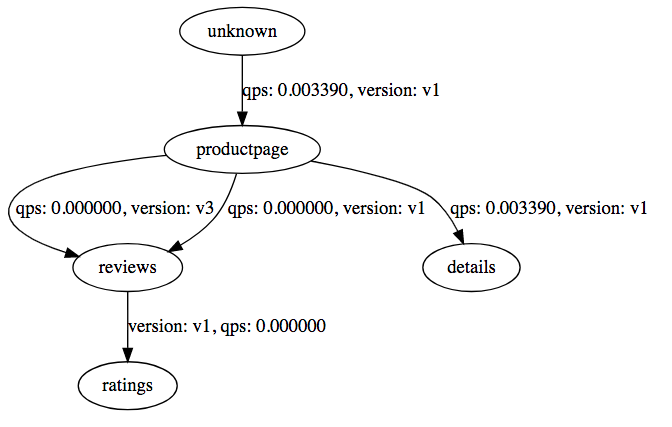

通过http://<kubernetes-ip>:31072/dotviz访问ServiceGraph服务,展示服务之间调用关系图

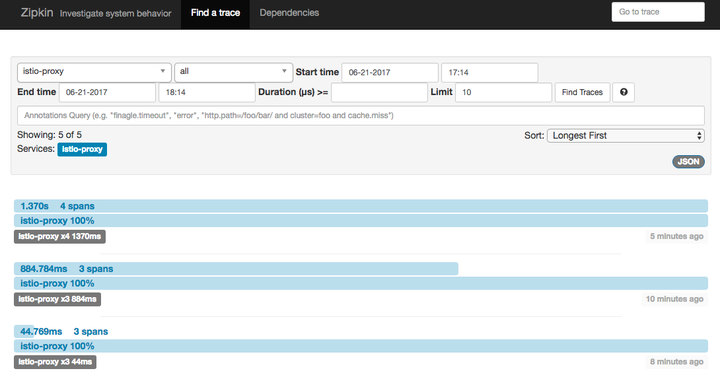

通过http://<kubernetes-ip>:30032访问Zipkin跟踪页面

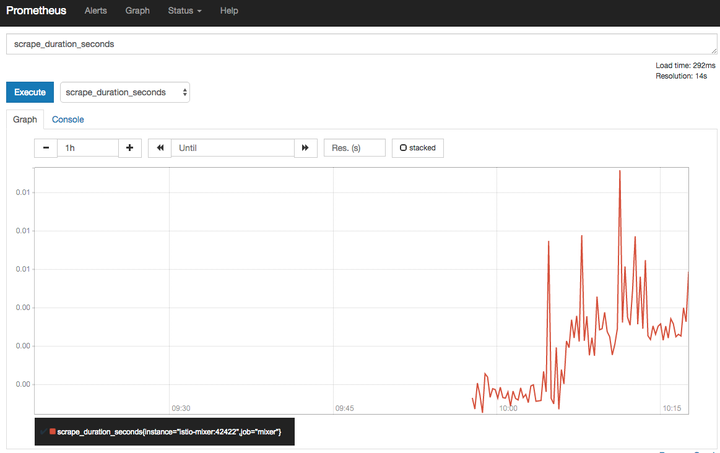

通过http://<kubernetes-ip>:30890访问Prometheus页面

部署示例应用

在部署应用时,需要通过istioctl kube-inject给Pod自动插入Envoy容器,即

kubectl create -f <(istioctl kube-inject -f <your-app-spec>.yaml)

比如Istio提供的BookInof示例:

kubectl apply -f <(istioctl kube-inject -f samples/apps/bookinfo/bookinfo.yaml)

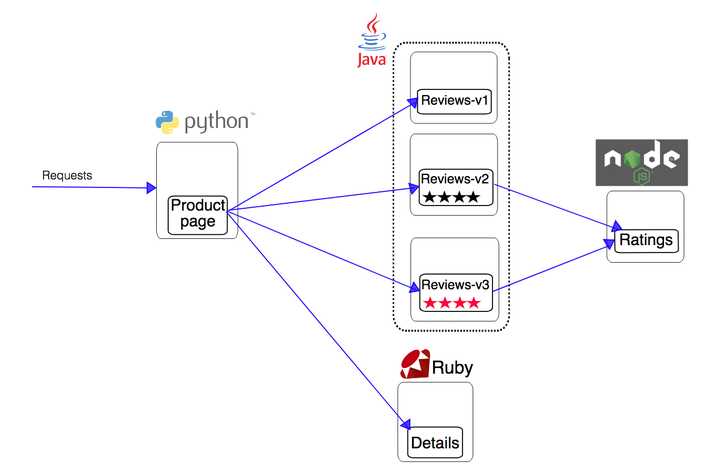

原始应用如下图所示

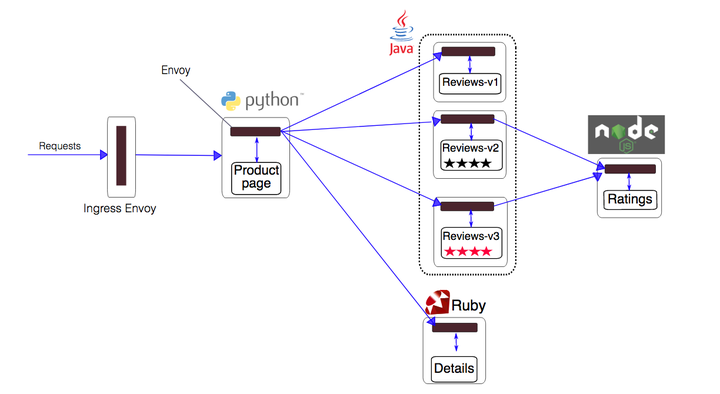

istioctl kube-inject在原始应用的每个Pod中插入了一个Envoy容器

服务启动后,可以通过Ingress地址http://<ingress-address>/productpage来访问BookInfo应用

$ kubectl describe ingress

Name: gateway

Namespace: default

Address: 192.168.0.77

Default backend: default-http-backend:80 (10.8.0.4:8080)

Rules:

Host Path Backends

---- ---- --------

*

/productpage productpage:9080 (<none>)

/login productpage:9080 (<none>)

/logout productpage:9080 (<none>)

Annotations:

Events: <none>